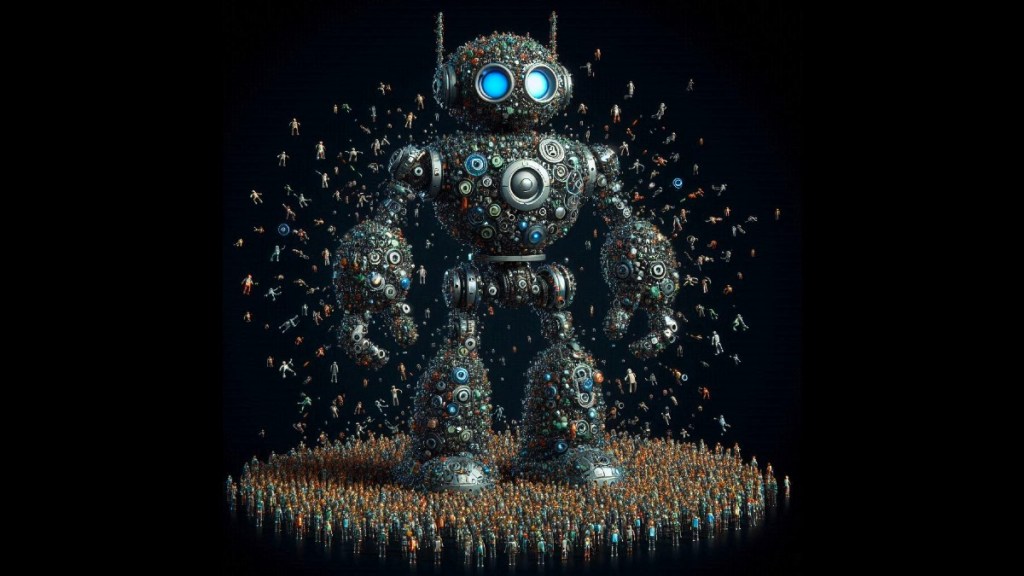

"Chain-of-Experts로 LLM의 효율성과 정확성을 혁신적으로 끌어올리다!"

제목 "Chain-of-experts (CoE): 효율성과 정확성을 높이는 저비용 LLM 프레임워크"에 대한 VentureBeat 기사는 Chain-of-Experts (CoE)라는 프레임워크를 사용하여 대형 언어 모델(LLM)의 성능과 효율성을 향상시키는 새로운 접근 방식을 논의합니다.

주요 내용

- Chain-of-Experts 프레임워크 : CoE 프레임워크는 다수의 에이전트가 협력하는 방식을 통해 LLM의 추론 능력을 개선하도록 설계되었습니다. 프레임워크의 각 에이전트 또는 전문가는 특정 도메인에 특화되어 있으며, 해당 분야의 지식과 추론 능력을 갖추고 있습니다.

- 전문가 특화 : CoE 프레임워크에서 각 전문가는 용어 해석, 모델링, 프로그래밍 또는 코드 리뷰와 같은 특정 역할이 부여됩니다. 이 전문들은 협력 문제 해결 과정을 안내하는 지휘자의 지휘 아래 함께 작업하며, 전방 사고 구성 및 후방 반영 메커니즘을 사용합니다.

- 효율성 및 비용 : CoE 프레임워크는 대형 LLM의 훈련 및 배포와 관련된 비용을 줄이는 것을 목표로 합니다. 각 전문가는 개별적으로 격리하여 훈련함으로써, 단일 대형 LLM을 훈련하는 데 필요한 방대한 계산 자원을 피할 수 있습니다. 이러한 접근 방식은 특정 작업에 필요한 전문가만 활성화하여 자원을 보다 효율적으로 사용할 수 있게 합니다.

- 성능 : 이 기사에 따르면, CoE 프레임워크는 다른 LLM 기반 추론 기준과 비교하여 우수한 성능을 보입니다. 이 프레임워크는 복잡한 운영 연구 문제에서 테스트되었으며, 수학적 추론 및 계획 생성과 같은 작업에서 상당한 개선 효과를 보여주었습니다.

- 확장성 : CoE 프레임워크는 고도로 확장 가능하여 작업의 요구사항에 따라 원하는 수의 전문가를 통합할 수 있습니다. 이 확장성은 거대한 단일 LLM 없이 다양하고 복잡한 작업을 처리하는 데 매우 중요합니다.

- 지속적인 학습 : 이 프레임워크는 지속적인 학습을 지원하여 전문가를 새로운 지식으로 별도로 미세 조정할 수 있게 합니다. 이 방식은 전체 LLM의 미세 조정에 드는 비용이 많이 드는 과정을 피할 수 있게 해줍니다. 이러한 기능은 최신 정보를 유지하는 데 매우 유용합니다.

요약하면, Chain-of-Experts 프레임워크는 여러 전문화된 전문가의 강점을 결합하여 LLM을 보다 효율적이고 비용 효과적이며 확장 가능한 방식으로 활용하여 다양한 분야에서 전체 성능과 정확성을 향상시킵니다.

주요 내용

- Chain-of-Experts 프레임워크 : CoE 프레임워크는 다수의 에이전트가 협력하는 방식을 통해 LLM의 추론 능력을 개선하도록 설계되었습니다. 프레임워크의 각 에이전트 또는 전문가는 특정 도메인에 특화되어 있으며, 해당 분야의 지식과 추론 능력을 갖추고 있습니다.

- 전문가 특화 : CoE 프레임워크에서 각 전문가는 용어 해석, 모델링, 프로그래밍 또는 코드 리뷰와 같은 특정 역할이 부여됩니다. 이 전문들은 협력 문제 해결 과정을 안내하는 지휘자의 지휘 아래 함께 작업하며, 전방 사고 구성 및 후방 반영 메커니즘을 사용합니다.

- 효율성 및 비용 : CoE 프레임워크는 대형 LLM의 훈련 및 배포와 관련된 비용을 줄이는 것을 목표로 합니다. 각 전문가는 개별적으로 격리하여 훈련함으로써, 단일 대형 LLM을 훈련하는 데 필요한 방대한 계산 자원을 피할 수 있습니다. 이러한 접근 방식은 특정 작업에 필요한 전문가만 활성화하여 자원을 보다 효율적으로 사용할 수 있게 합니다.

- 성능 : 이 기사에 따르면, CoE 프레임워크는 다른 LLM 기반 추론 기준과 비교하여 우수한 성능을 보입니다. 이 프레임워크는 복잡한 운영 연구 문제에서 테스트되었으며, 수학적 추론 및 계획 생성과 같은 작업에서 상당한 개선 효과를 보여주었습니다.

- 확장성 : CoE 프레임워크는 고도로 확장 가능하여 작업의 요구사항에 따라 원하는 수의 전문가를 통합할 수 있습니다. 이 확장성은 거대한 단일 LLM 없이 다양하고 복잡한 작업을 처리하는 데 매우 중요합니다.

- 지속적인 학습 : 이 프레임워크는 지속적인 학습을 지원하여 전문가를 새로운 지식으로 별도로 미세 조정할 수 있게 합니다. 이 방식은 전체 LLM의 미세 조정에 드는 비용이 많이 드는 과정을 피할 수 있게 해줍니다. 이러한 기능은 최신 정보를 유지하는 데 매우 유용합니다.

요약하면, Chain-of-Experts 프레임워크는 여러 전문화된 전문가의 강점을 결합하여 LLM을 보다 효율적이고 비용 효과적이며 확장 가능한 방식으로 활용하여 다양한 분야에서 전체 성능과 정확성을 향상시킵니다.